阿里巴巴推出的QwQ-32B是一款開源AI模型,擁有325億參數,專注於邏輯推理和複雜問題解決,部分表現超越GPT4o及Sonnet 3.5,更有望挑戰OpenAI o1

Qwen QwQ-32B-Preview模型介紹 | 能打敗o1的開源推理模型?

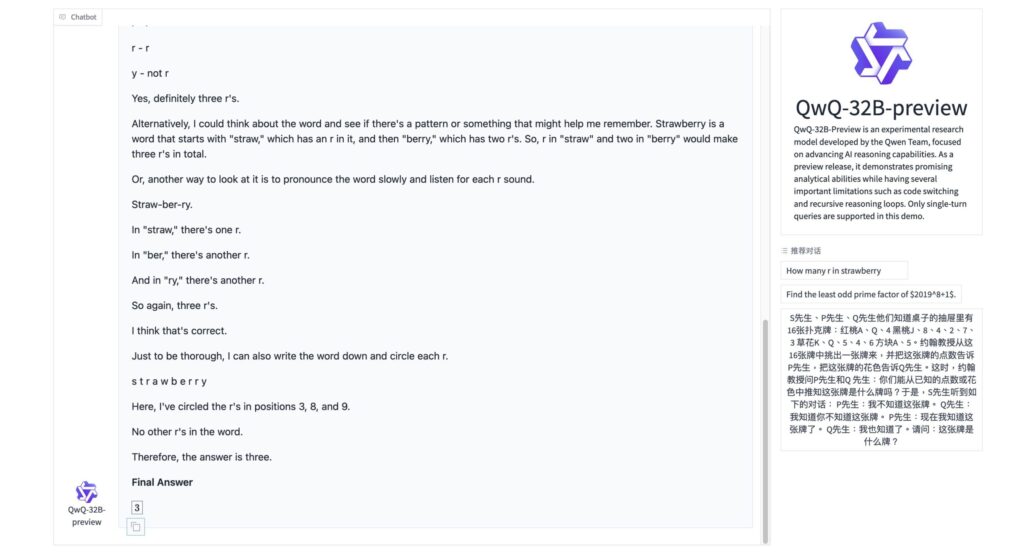

阿里巴巴近期推出了名為 QwQ-32B-Preview 的人工智慧推理模型,這是一款具備 325 億個參數 的實驗性研究模型,專注於邏輯推理與問題解決能力。該模型的脈絡長度可達 32,768 個 Tokens,在多項基準測試中表現優異,特別是在數學和程式生成方面。

立即在HuggingFace Space上試玩QwQ-32B-Preview

Qwen QwQ的參數與性能

QwQ-32B-Preview 的參數規模達到 325 億,這使其在處理複雜的語言任務時能夠展現出強大的性能。在 AIME 和 MATH-500 等數學能力基準測試中,該模型的表現超過了 OpenAI 的 o1-preview 模型。具體來說:

- 在 AIME 測試中,QwQ-32B-Preview 的得分為 50.0,而 OpenAI 的 o1-preview 為 44.6。

- 在 MATH-500 測試中,QwQ-32B-Preview 的得分為 90.6,顯示出其在數學解題能力上的優越性。

此外,它在 LiveCodeBench 測試中的表現也相當不錯,得分為 50.0。

Qwen QwQ的開源協議

QwQ-32B-Preview 是以 Apache 2.0 授權協議開源的,這意味著開發者可以自由使用和修改該模型,用於商業用途。這一特性使得 QwQ 成為技術開發和學術研究中的一個重要工具。

Qwen QwQ的局限性

儘管QwQ-32B-Preview在多項測試中展現了優異的性能,但它仍然存在一些明顯的局限性。

首先,語言混合問題是使用者常遇到的挑戰之一。模型在回答問題時,可能會不自覺地混合使用不同的語言,這樣的現象會影響表達的連貫性,讓讀者難以理解其意圖。常見的情型是當用戶以英文提問,QwQ-32B-Preview回答時有機會夾雜簡體中文。

其次,在處理複雜邏輯問題時,模型有時會出現推理循環的情況。這意味著它可能會陷入無窮迴圈,導致回答變得冗長且缺乏重點,無法有效解決問題。

最後,儘管QwQ-32B-Preview已經設置了一定的安全性考量機制,但模型仍有可能生成不恰當或帶有偏見的回答。這對於用戶來說,是一個需要特別注意的風險,尤其是在涉及敏感話題時。

未來展望

隨著人工智慧技術的不斷進步,QwQ 系列模型有望在教育、科研及商業領域發揮更大的作用。它不僅能幫助學生解決數學和程式設計問題,也能成為企業提升工作效率的重要工具。未來,隨著持續的優化和改進,QwQ 將展現出更強大的推理能力和更廣泛的應用潛力。